Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Python став однією з найпопулярніших мов програмування завдяки величезній екосистемі бібліотек. Ці готові інструменти дозволяють розробникам вирішувати складні завдання без необхідності писати код з нуля. Якщо ви хочете стати ефективним Python-розробником у 2025 році, знання правильних бібліотек — це не просто перевага, а необхідність.

У цій статті я розповім про десять найкращих Python libraries, які використовую щодня. Це не просто теоретичний огляд — я поділюся реальними прикладами та пояснюваннями, які допоможуть вам почати використовувати ці інструменти вже сьогодні.

NumPy (Numerical Python) — це абсолютна основа для будь-яких чисельних обчислень у Python. Якщо ви працюєте з масивами даних, матрицями або виконуєте математичні операції, NumPy має бути вашим першим вибором.

Чому NumPy такий швидкий? Бібліотека написана на C, що робить операції над масивами в 50-100 разів швидшими, ніж стандартні списки Python. Основна структура даних — це ndarray (N-dimensional array), яка дозволяє ефективно працювати з багатовимірними даними.

import numpy as np

# Створення масиву

arr = np.array([1, 2, 3, 4, 5])

# Векторні операції (без циклів!)

squared = arr ** 2

print(squared) # [1 4 9 16 25]

# Багатовимірні масиви

matrix = np.array([[1, 2, 3], [4, 5, 6]])

print(matrix.shape) # (2, 3)

# Математичні функції

mean = np.mean(arr)

std_dev = np.std(arr)

print(f"Середнє: {mean}, Стандартне відхилення: {std_dev}")Code language: PHP (php)Переваги: Неймовірна швидкість, підтримка широкого спектру математичних функцій, основа для інших бібліотек (Pandas, SciPy, TensorFlow).

Недоліки: Крива навчання для початківців, які не знайомі з матрицями та векторними операціями.

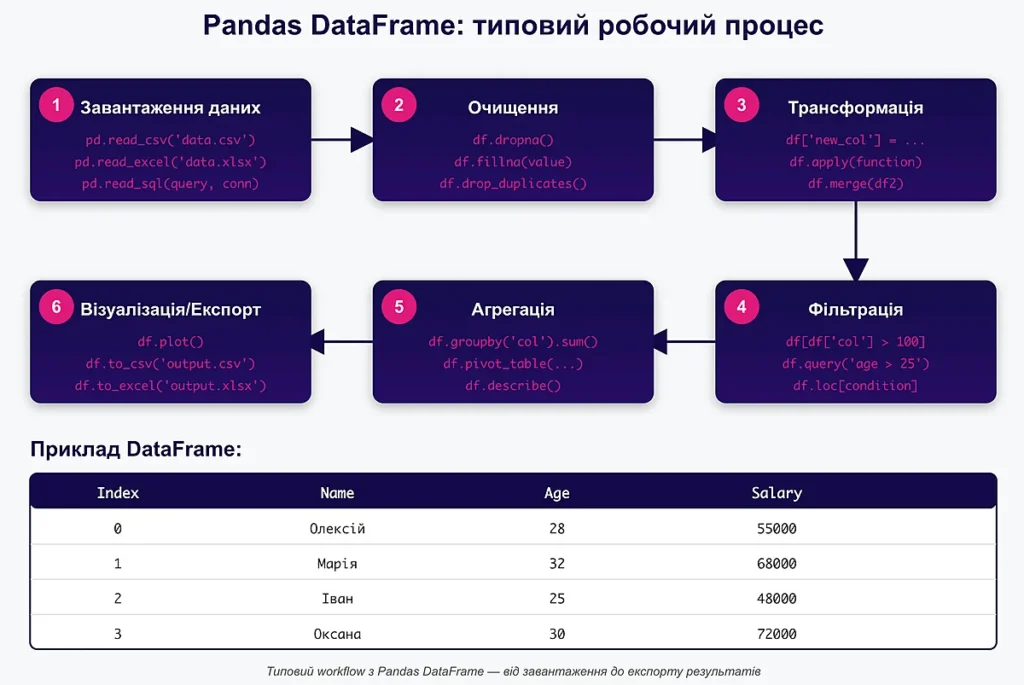

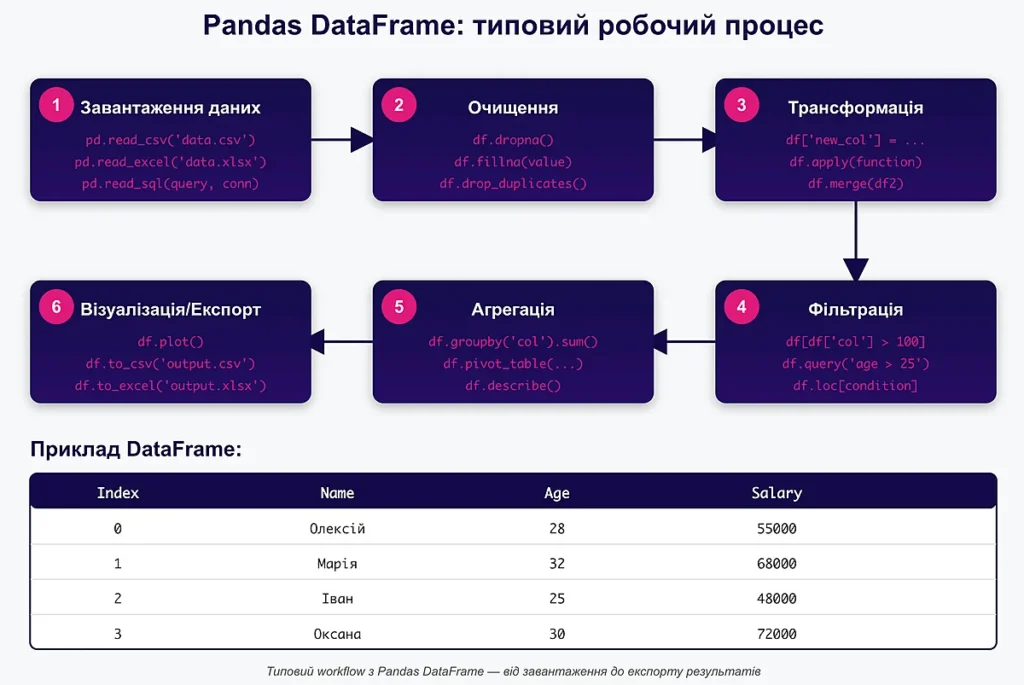

Якщо NumPy — це двигун, то Pandas (Python libraries) — це повноцінний автомобіль для роботи з даними. Ця бібліотека надає дві ключові структури: Series (одновимірні дані) та DataFrame (таблиці даних). Pandas дозволяє легко завантажувати, очищати, трансформувати та аналізувати дані.

import pandas as pd

# Створення DataFrame

data = {

'name': ['Олег', 'Марія', 'Іван', 'Оля'],

'age': [25, 30, 35, 28],

'salary': [50000, 65000, 75000, 58000]

}

df = pd.DataFrame(data)

# Фільтрація даних

high_earners = df[df['salary'] > 60000]

print(high_earners)

# Групування та агрегація

avg_salary = df.groupby('age')['salary'].mean()

# Читання з CSV

# df = pd.read_csv('data.csv')

# Швидка статистика

print(df.describe())Code language: PHP (php)Pandas особливо корисний, коли ви працюєте з CSV, Excel файлами, SQL базами даних або JSON. Функції типу read_csv(), read_excel() та to_sql() роблять інтеграцію даних надзвичайно простою.

Переваги: Потужні інструменти для очищення та трансформації даних, інтеграція з багатьма форматами файлів, відмінна документація.

Недоліки: Може бути повільним на дуже великих датасетах (мільйони рядків), високе споживання пам’яті.

Matplotlib — це ветеран візуалізації даних у Python. Хоча зараз існують більш сучасні альтернативи, Matplotlib залишається стандартом де-факто завдяки своїй гнучкості та потужності.

import matplotlib.pyplot as plt

import numpy as np

# Простий лінійний графік

x = np.linspace(0, 10, 100)

y = np.sin(x)

plt.figure(figsize=(10, 6))

plt.plot(x, y, label='sin(x)', color='blue', linewidth=2)

plt.xlabel('X axis')

plt.ylabel('Y axis')

plt.title('Синусоїда')

plt.legend()

plt.grid(True, alpha=0.3)

plt.show()

# Гістограма

data = np.random.randn(1000)

plt.hist(data, bins=30, alpha=0.7, color='green')

plt.title('Розподіл даних')

plt.show()Code language: PHP (php)Переваги: Повний контроль над кожним елементом графіка, широка підтримка типів діаграм, відмінна інтеграція з Jupyter Notebooks.

Недоліки: Багатослівний синтаксис, застарілий дизайн графіків за замовчуванням, складніше створювати інтерактивні візуалізації.

Scikit-learn — це найпопулярніша бібліотека для машинного навчання у Python. Вона надає простий і послідовний інтерфейс для класифікації, регресії, кластеризації та багатьох інших ML-завдань.

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error, r2_score

import numpy as np

# Генеруємо дані

X = np.array([[1], [2], [3], [4], [5], [6], [7], [8]])

y = np.array([2, 4, 5, 4, 5, 7, 8, 9])

# Розділяємо на тренувальні та тестові

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# Створюємо та тренуємо модель

model = LinearRegression()

model.fit(X_train, y_train)

# Прогнозуємо

predictions = model.predict(X_test)

# Оцінюємо якість

mse = mean_squared_error(y_test, predictions)

r2 = r2_score(y_test, predictions)

print(f"MSE: {mse:.2f}, R²: {r2:.2f}")Code language: PHP (php)Scikit-learn особливо сильний у класичному ML: лінійна регресія, дерева рішень, випадковий ліс, SVM, кластеризація k-means. Для глибокого навчання краще використовувати TensorFlow або PyTorch.

Переваги: Консистентний API, чудова документація з прикладами, вбудовані датасети для навчання.

Недоліки: Не підтримує GPU, не найкращий вибір для глибокого навчання або обробки зображень.

TensorFlow — це потужна платформа для побудови та тренування моделей глибокого навчання. Розроблена командою Google Brain, вона підтримує як CPU, так і GPU обчислення, що робить її ідеальною для складних нейронних мереж.

import tensorflow as tf

from tensorflow import keras

import numpy as np

# Завантаження датасету MNIST

(X_train, y_train), (X_test, y_test) = keras.datasets.mnist.load_data()

# Нормалізація даних

X_train = X_train / 255.0

X_test = X_test / 255.0

# Створення простої нейронної мережі

model = keras.Sequential([

keras.layers.Flatten(input_shape=(28, 28)),

keras.layers.Dense(128, activation='relu'),

keras.layers.Dropout(0.2),

keras.layers.Dense(10, activation='softmax')

])

# Компіляція

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# Тренування

model.fit(X_train, y_train, epochs=5, validation_split=0.2)

# Оцінка

test_loss, test_acc = model.evaluate(X_test, y_test)

print(f'Точність на тестових даних: {test_acc:.4f}')Code language: PHP (php)Переваги: Підтримка GPU/TPU, величезна екосистема інструментів (TensorBoard, TF Lite), виробничий рівень.

Недоліки: Крута крива навчання, іноді надмірно складний для простих завдань.

PyTorch, розроблений Meta (Facebook), швидко став улюбленою бібліотекою серед дослідників AI та data scientists. Його динамічні обчислювальні графи роблять код більш інтуїтивним та Python-подібним. (Python libraries)

import torch

import torch.nn as nn

import torch.optim as optim

# Створення простої моделі

class SimpleNN(nn.Module):

def __init__(self):

super(SimpleNN, self).__init__()

self.fc1 = nn.Linear(784, 128)

self.fc2 = nn.Linear(128, 10)

self.relu = nn.ReLU()

def forward(self, x):

x = x.view(-1, 784) # Flatten

x = self.relu(self.fc1(x))

x = self.fc2(x)

return x

# Ініціалізація

model = SimpleNN()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# Тренування (псевдокод)

# for epoch in range(epochs):

# outputs = model(inputs)

# loss = criterion(outputs, labels)

# optimizer.zero_grad()

# loss.backward()

# optimizer.step()Переваги: Простіший та інтуїтивніший синтаксис, відмінна підтримка дослідницьких проєктів, активна спільнота.

Недоліки: Менше інструментів для production deployment порівняно з TensorFlow.

Requests — це найпопулярніша Python library для роботи з HTTP. Вона робить API-запити настільки простими, що ви забудете про складнощі протоколу HTTP.

import requests

import json

# GET запит

response = requests.get('https://api.github.com/users/octocat')

if response.status_code == 200:

data = response.json()

print(f"Користувач: {data['login']}, Repos: {data['public_repos']}")

# POST запит з даними

payload = {'username': 'testuser', 'password': 'secret'}

headers = {'Content-Type': 'application/json'}

response = requests.post('https://httpbin.org/post',

data=json.dumps(payload),

headers=headers)

# Завантаження файлу

url = 'https://example.com/image.jpg'

response = requests.get(url, stream=True)

if response.status_code == 200:

with open('image.jpg', 'wb') as f:

for chunk in response.iter_content(1024):

f.write(chunk)Code language: PHP (php)Переваги: Надзвичайно проста у використанні, підтримує сесії, cookies, автентифікацію.

Недоліки: Синхронна (блокуюча), для асинхронних запитів краще використовувати aiohttp.

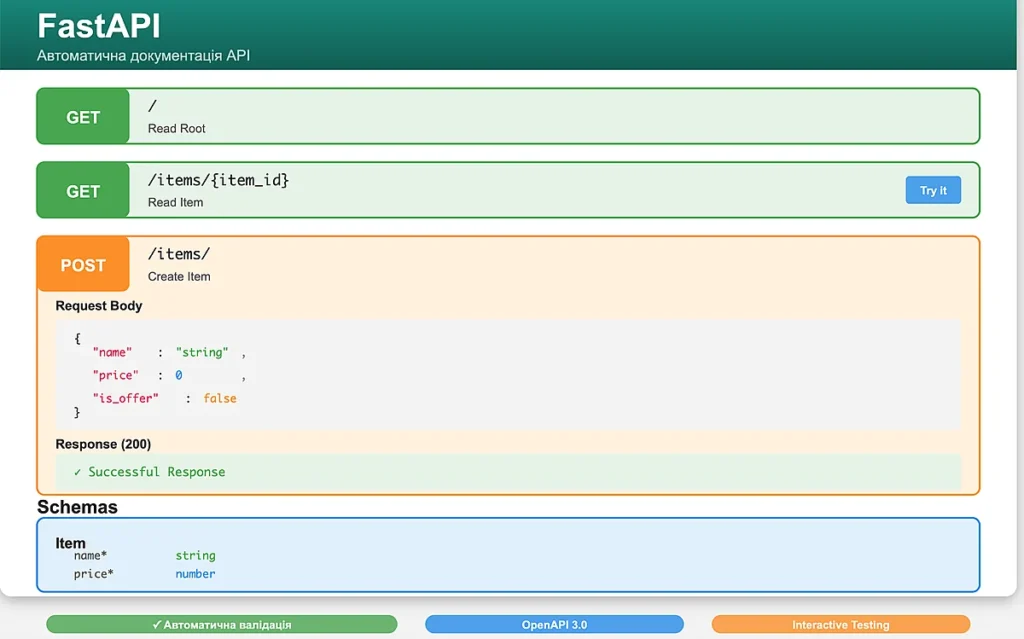

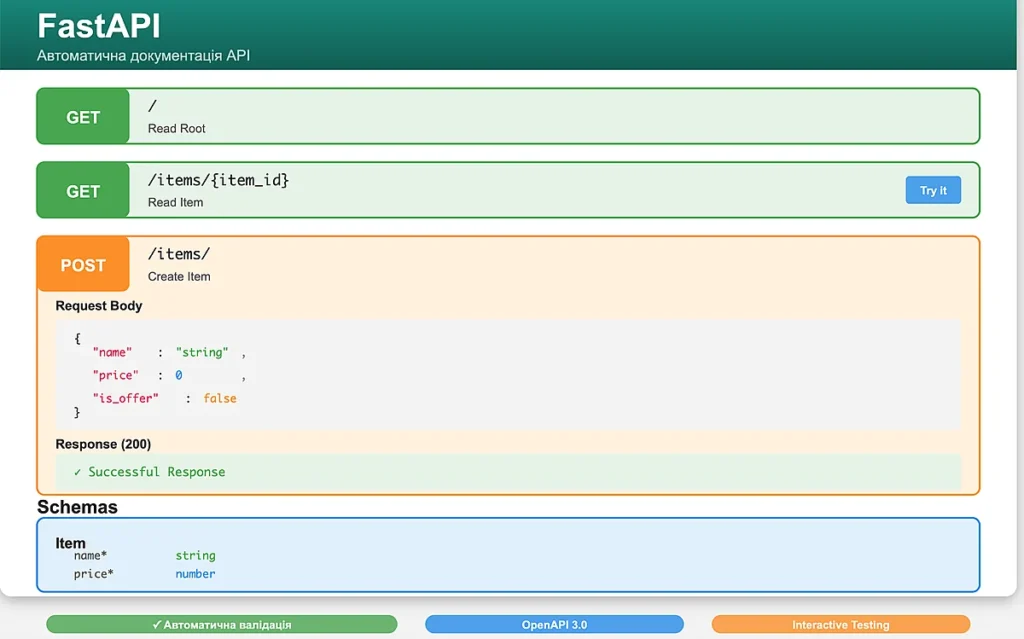

FastAPI — це новий гравець у світі Python веб-фреймворків, але він швидко захопив серця розробників. Побудований на Starlette та Pydantic, він надає неймовірну продуктивність і автоматичну документацію API.

from fastapi import FastAPI

from pydantic import BaseModel

app = FastAPI()

class Item(BaseModel):

name: str

price: float

is_offer: bool = False

@app.get("/")

async def read_root():

return {"message": "Вітаємо у FastAPI!"}

@app.get("/items/{item_id}")

async def read_item(item_id: int, q: str = None):

return {"item_id": item_id, "q": q}

@app.post("/items/")

async def create_item(item: Item):

return {"item": item.name, "price": item.price}

# Запуск: uvicorn main:app --reload

# Автоматична документація: http://localhost:8000/docsПереваги: Висока продуктивність, автоматична валідація даних, генерація OpenAPI документації, асинхронна підтримка.

Недоліки: Молода екосистема порівняно з Django/Flask, менше готових рішень.

SciPy Python libraries будується на NumPy і надає додаткові інструменти для наукових та інженерних обчислень. Це оптимізація, інтеграція, інтерполяція, обробка сигналів, лінійна алгебра та багато іншого.

from scipy import optimize, integrate

import numpy as np

# Оптимізація функції

def f(x):

return x**2 + 10*np.sin(x)

result = optimize.minimize(f, x0=0)

print(f"Мінімум знайдено в точці: {result.x[0]:.4f}")

# Інтегрування

def integrand(x):

return np.exp(-x**2)

result, error = integrate.quad(integrand, 0, np.inf)

print(f"Інтеграл: {result:.4f}")

# Розв'язання системи лінійних рівнянь

from scipy import linalg

A = np.array([[3, 1], [1, 2]])

b = np.array([9, 8])

x = linalg.solve(A, b)

print(f"Розв'язок: x = {x}")Code language: PHP (php)Переваги: Широкий спектр наукових інструментів, оптимізовані алгоритми, добре протестовано.

Недоліки: Потребує розуміння математики, складна для початківців.

Beautiful Soup робить парсинг HTML та XML документів надзвичайно простим. Якщо вам потрібно витягнути дані з веб-сторінок, ця бібліотека — ваш найкращий друг.

from bs4 import BeautifulSoup

import requests

# Завантаження сторінки

url = 'https://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.content, 'html.parser')

# Пошук елементів

title = soup.find('title').text

print(f"Заголовок: {title}")

# Знаходження всіх посилань

links = soup.find_all('a')

for link in links[:5]: # Перші 5 посилань

href = link.get('href')

text = link.text.strip()

print(f"{text}: {href}")

# Пошук за CSS селектором

articles = soup.select('div.article')

for article in articles:

heading = article.find('h2').text

print(f"Стаття: {heading}")

# Пошук за атрибутами

images = soup.find_all('img', {'class': 'thumbnail'})

for img in images:

print(img.get('src'))Code language: PHP (php)Beautiful Soup чудово поєднується з Requests для створення потужних веб-скрейперів. Для більш складних завдань можна використовувати Selenium або Scrapy.

Переваги: Проста у вивченні, толерантна до поганого HTML, гнучкі методи пошуку.

Недоліки: Повільніше на великих документах, не виконує JavaScript (потрібен Selenium).

Вибір бібліотеки залежить від специфіки вашого завдання. Ось швидкий гайд:

Всі ці бібліотеки легко встановлюються через pip:

# Встановлення однієї бібліотеки

pip install numpy

# Встановлення кількох бібліотек одразу

pip install pandas matplotlib scikit-learn

# Встановлення конкретної версії

pip install tensorflow==2.15.0

# Встановлення з requirements.txt

pip install -r requirements.txt

# Оновлення бібліотеки

pip install --upgrade requestsCode language: PHP (php)Рекомендую завжди використовувати віртуальні середовища для ізоляції залежностей проєктів. Це запобігає конфліктам версій і робить проєкти більш переносимими.

Хоча я вибрав топ-10, існує ще багато чудових бібліотек, які варті вашої уваги:

За роки роботи з Python я навчився кільком важливим принципам, які допомагають ефективніше використовувати бібліотеки:

Екосистема Python постійно розвивається. У 2025 році помітні кілька цікавих трендів:

Знання цих десяти Python libraries — це міцний фундамент для будь-якого Python-розробника. NumPy та Pandas для роботи з даними, Scikit-learn для ML, TensorFlow або PyTorch для глибокого навчання, Requests та Beautiful Soup для веб-взаємодії, FastAPI для створення API — разом вони покривають більшість практичних завдань.

Не намагайтеся вивчити все одразу. Почніть з однієї-двох бібліотек, які найбільше відповідають вашим поточним потребам. Практикуйтеся на реальних проєктах, читайте чужий код, експериментуйте. З часом ви побачите, як ці інструменти стають природною частиною вашого робочого процесу.

Для подальшого вивчення рекомендую відвідати офіційні ресурси:

Якщо вас зацікавила ця тема, ознайомтеся з іншими корисними статтями на нашому блозі:

Успіхів у вивченні Python! Пам’ятайте: найкращий спосіб освоїти бібліотеку — це почати її використовувати в реальному проєкті. Не бійтеся експериментувати, помилятися та вчитися на власному досвіді.